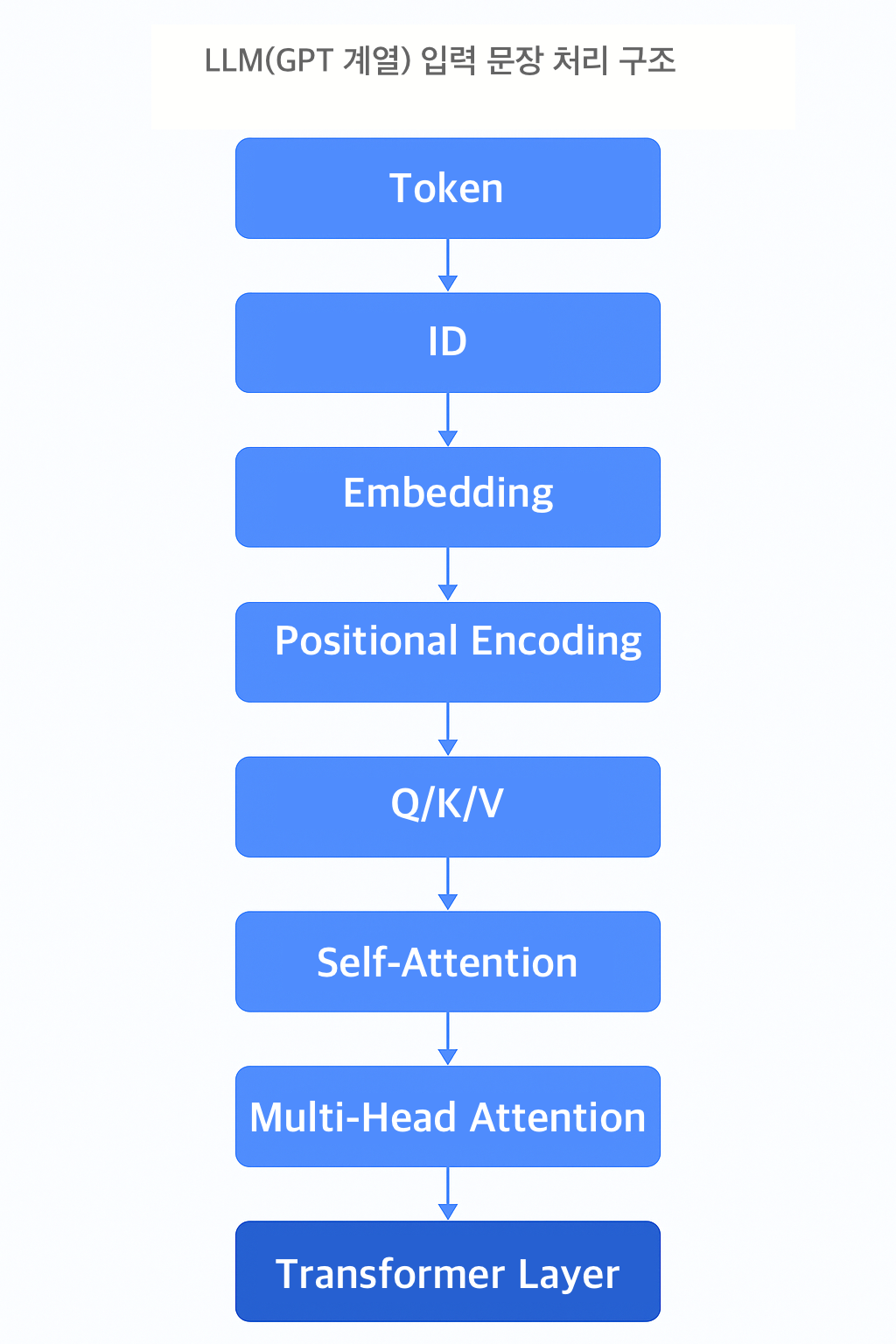

이 글은 GPT의 문맥 이해 방식에 핵심이 되는 어텐션과 트랜스포머 구조를 실제 질문 기반 사례를 통해 쉽게 설명합니다. LLM 구조의 작동 원리를 사고 흐름 중심으로 정리했습니다.그리고 이 글은 Token / Embedding / RAG의 개념을 알고 있으면 더 이해하기 쉽습니다. 들어가며: 이 구조가 왜 중요한가?GPT가 놀라운 건 단어 하나만 잘 고르는 게 아니라, 앞뒤 맥락을 이어서 말한다는 점이다. 나는 이걸 처음 접했을 때 가장 궁금했다."이런 문장 흐름을 기계가 어떻게 이해하지?"이 질문은 결국 트랜스포머의 핵심, 어텐션(attention) 개념으로 이어졌다. 이 글은 이 개념을 최대한 쉽게 풀어보고, 실제로 내가 GPT에게 던졌던 질문들을 기반으로 흐름을 따라가 본다.1. 단어 사이의 연..